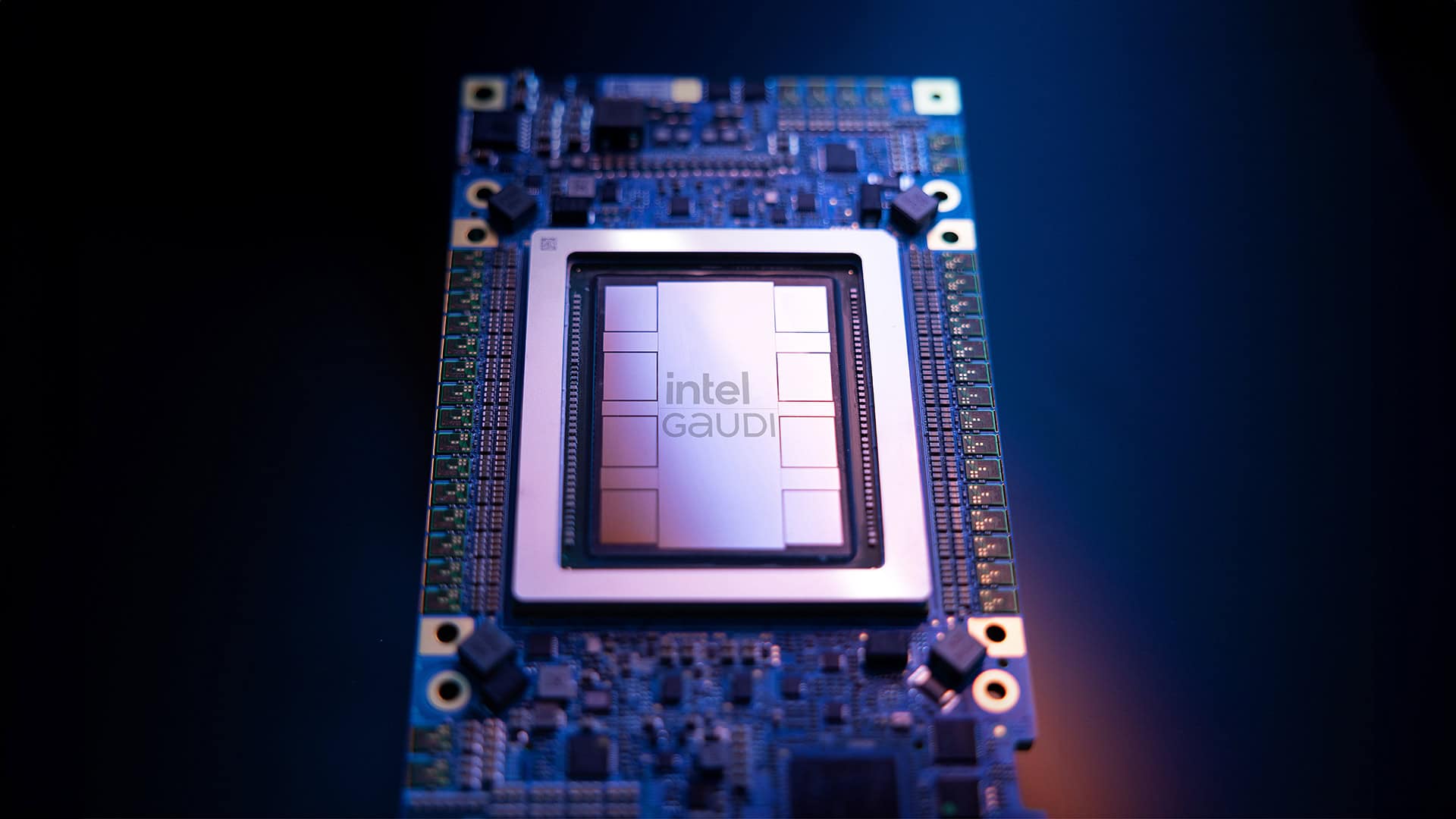

IBMとIntelが画期的な提携を発表した。IBMが主要クラウドサービスプロバイダーとして初めてIntelのGaudi 3 AI加速器を採用し、2025年初頭からIBM Cloudで提供を開始する。この動きは、急速に成長するAI市場において、両社の競争力強化を図る戦略的な一手となる。

IBMとIntelの提携がAI業界に与える影響

IBMは、Intel Gaudi 3 AIアクセラレータをIBM Cloudのサービスとして展開する計画を明らかにした。この提供は2025年初頭に開始される見込みで、エンタープライズAIのより効果的なスケーリングとイノベーション促進を目的としている。さらに、IBMのAIおよびデータプラットフォームであるwatsonxにおいてもGaudi 3のサポートが予定されている。

IntelのJustin Hotard氏(データセンターおよびAI部門のエグゼクティブVPおよびGM)は次のように述べている。「AIの可能性を最大限に引き出すには、顧客に選択肢と利用しやすいソリューションを提供するオープンで協調的なエコシステムが必要です。Gaudi 3 AI加速器とXeon CPUをIBM Cloudと統合することで、新たなAI機能を創出し、手頃な価格で安全かつ革新的なAIコンピューティングソリューションへの需要に応えています」。

この提携は、AI市場におけるNVIDIAの優位性に挑戦する動きとして注目される。IBMとIntelは、AIワークロードの総所有コスト削減と性能向上を目指しており、特に規制の厳しい業界を含む幅広い分野での活用を視野に入れている。

Gaudi 3の性能特性とIntelの市場戦略

Gaudi 3は、IntelがHabana Labsの20億ドル買収を通じて獲得したAI加速器シリーズの最新モデルである。TSMCの5nmプロセスで製造され、以下の2種類の専用計算モジュールを搭載している:

- TPC(Tensor Processing Cluster)モジュール:VLIW(Very Long Instruction Word)アーキテクチャを採用し、より複雑な計算に対応。

- MME(Matrix Multiplication Engine)モジュール:マトリックス乗算に最適化され、AI モデルの基本的な計算処理を担当。

性能面では、Gaudi 3は前世代の製品と比較して大幅な向上を実現している。TPCの数は約3倍、MMEは4倍に増加し、120GBの高速メモリを搭載。BF16データ形式での処理速度は1,835 TFLOPSに達する。さらに、チップ間およびサーバー間の接続に使用されるオンボードEthernetモジュールのリンク帯域幅を200Gbpsに倍増させている。

IntelはGaudi 3のパフォーマンスをNVIDIA H100と比較し、推論タスクにおいて最大2.3倍の電力効率を実現し、一部の大規模言語モデルのトレーニング時間を短縮できると主張している。しかし、NVIDIAの最新チップBlackwellの登場により、競争はさらに激化する見込みだ。

IBMとIntelの提携は、両社にとって重要な意味を持つ。IBMにとっては、AIインフラストラクチャの選択肢を拡大し、顧客に柔軟なソリューションを提供する機会となる。一方Intelは、AIチップ市場でのシェア拡大を目指す中で、主要クラウドプロバイダーによる採用という重要な一歩を踏み出した。

2025年初頭のサービス開始に向けて、両社は継続的に協力関係を深めていく予定だ。この提携が、AI市場の競争環境にどのような変化をもたらすか、今後の動向が注目される。

Sources

コメント