OpenAIは本日オンラインイベントを開催し、オーディオ、ビジョン、テキストを“リアルタイム”で推論できる新たな基幹モデルである「GPT-4o」(oはOmniを表す)を発表した。ネーミングからすると、OpenAIの中でこれはGPT-4の漸進的なバージョンアップという位置づけかも知れないが、その進化はパフォーマンスと効率性において新たな基準を打ち立てるものでもある。

テキスト、ビジョン、オーディオの入出力を同じニューラルネットワークで処理する初めてのモデル

これまでのトップレベルのモデルだったGPT-4 Turboを上回る性能を示すことはもちろんの事ながら、特筆すべきは、GPT-4oの“o”が表す“Omni(全ての)”と言う接尾語に集約されているように、このモデルがテキスト、ビジョン、オーディオの全ての入力と出力を同じニューラルネットワークで処理するマルチモーダル・モデルであり、人間のユーザーとの自然な対話を実現するリアルタイムの応答性を備えていることである。

GPT-4oの進化はAppleのSiriやGoogleアシスタントを酷く原始的なレベルに見せる物だ。言葉で語るより実際のビデオをご覧頂くのが一番だろう。以下の動画は全て等倍速で撮影しているという。

事前の知識がない状態でこのビデオをご覧になったならば、恐らくAIと対話しているとは思えないのではないだろうか。それほどまでに自然で、感情表現豊かなやりとりが再現されている事に驚きを禁じ得ない。

アシスタントの音声応答は、映画『her』でScarlett Johanssonが演じる高度なAI「Samantha」のキャラクターに驚くほど似てるものだった。

OpenAIのCEOであるSam Altman氏もこれを指摘し、「her」と投稿している。

これまでにもChatGPTのインターフェースで音声チャットのやりとりは可能だったが、使った事のある方ならご存じのように、こちらの入力に対する応答は待たされるのが当たり前だった。OpenAIによれば、GPT-3.5で平均2.8秒、GPT-4では5.4秒だという。これが最新のGPT-4oでは、実に232ミリ秒(0.232秒)、平均では320ミリ秒(0.32秒)にまで短縮されており、人間の応答時間とほぼ同じレベルにまで高められているという。ただし、これは英語音声でのやりとりの場合であり、日本語やその他の言語でどの程度まで応答速度が上がっているのかは今後の検証が待たれる。

GPT-4oはまた、穏やかな呼吸と興奮した呼吸を区別し、合成音声で様々な感情を表現し、要求に応じてロボット風の音声に変えたり、歌を歌ったりすることも出来るなど、ユニークな機能も備えているという。

モデルのパフォーマンス自体ももちろん高く、英語のテキスト処理についてはGPT-4 Turboに匹敵する上に遥かに高速に処理でき、英語以外の言語では GPT-4 Turboを大幅に上回るという。

GPT-4oはGPT-4 Turboより効率的で安価

OpenAIによると、GPT-4oの開発においては効率性についても重要な焦点が置かれて開発されたという。OpenAIによれば、GPT-4oはGPT-4 Turboより2倍速く、50%安いとの事だ。

更に驚くべき事に、OpenAIはこのGPT-4oをChatGPTの無料ユーザー枠でも利用できるようにした。OpenAIによれば世界最高のGPT-4レベルのモデルが無料で公開されるのは初めてのことだ。なお、ChatGPTの有料会員であるChatGPT Plusユーザーももちろん引き続き利用でき、無料ユーザーの5倍のレート制限枠で利用出来る事や、DALL-Eによる画像生成にアクセス出来るなどの特典が利用できる。ただし、これまでGPT-4が利用できるからと言う事でChatGPT Plusに加入していたユーザーも、GPT-4oが無料で提供され、そもそもそこまでの頻度で利用しないのならば無料ユーザーに戻そうという動きも現れそうだ。

開発者は、テキストと「ビジョン」モデルとしてAPIでGPT-4oを使用することができ、今後数週間のうちに、信頼できるパートナーの選択されたグループに音声とビデオ機能を提供する予定である。

「OpenAIを始めた当初の構想では、AIを作り、それを使って世の中に様々な利益を生み出すというものでした。そうではなく、私たちがAIを作り、他の人々がそれを使って、私たち全員が恩恵を受けられるような、様々な素晴らしいものを作り出すということです」と、OpenAIのCEOであるSam Altman氏は自身のブログで述べている。

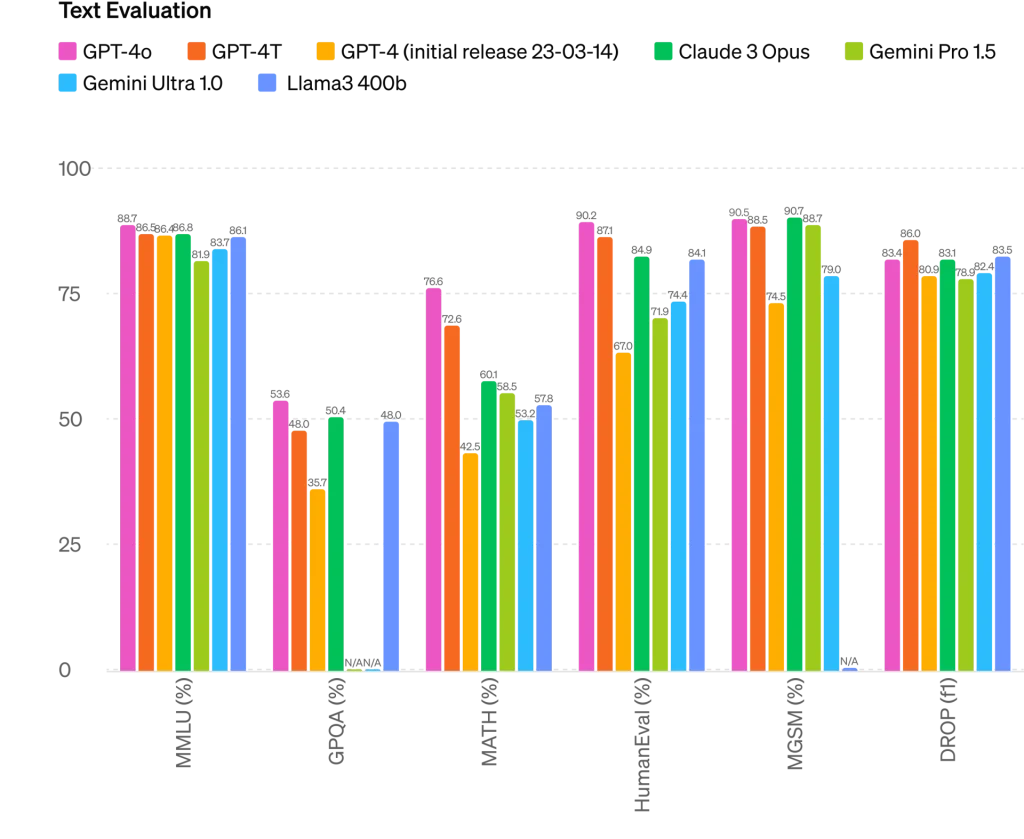

GPT-4oはGPT-4 Turboを上回る性能を示す

GPT-4oの性能を実証するために、OpenAIは言語モデルのベンチマークであるLMSys Arenaでモデルをテストした。OpenAIの研究者であるWilliam Fedusによると、GPT-4oはその前身であるGPT-4 Turboを約60ELOポイント上回ったとのことで、まさに“頭一つ抜けた”性能を示している。

ELOスコアは、モデルの実際の出力を使った人間によるブラインドテストで評価されるため、現在、モデルの性能を示す最も重要な指標のひとつと考えられている。ELOは、もともとチェスで相対的なプレーの強さを測るために使われていた評価システムである。ELOのレーティングが高ければ高いほど、プレーヤー(この場合はAIモデル)の成績が良いことを意味する。データはチャットボット・アリーナからのもので、OpenAIは最近、gpt2と言う偽名でモデルを競わせていた。これがGPT-5なのではないかと一部界隈では噂されたが、結局の所これはGPT-4oだったわけだ。

GPT-4oは困難なタスク、特にプログラミングにおいて、GPT-4 Turboより100ポイント高いELOスコアを達成している。

OpenAIによると、GPT-4oは従来のテキスト、推論、プログラミングのベンチマークではGPT-4 Turboの性能に匹敵し、多言語、音声、視覚理解では新たなベンチマークを打ち立てたという。

例えば、GPT-4oは一般知識テスト(MMLU, 5-Shot)で87.2%という新記録を達成した。また、音声認識や翻訳、図を含むタスク(M3Exam)においても、GPT-4や他のモデルを大きく上回っている。特にGPT-4oは、視覚認識テストにおいても新たな基準を打ち立てたと、OpenAIは主張している。

また、GPT-4oの新しいトークナイザーは、言語をより効率的にトークンに分解し、処理を高速化し、特に非ラテンスクリプトのメモリ要件を削減することが出来るとのことだ。例えば、”Hello, my name is GPT-4o “という文に必要なトークンは、テルグ語で3.5倍、日本語で1.4倍少なくなっている。

GPT-4oは本日よりChatGPTにて利用可能となっている。今のところ、公開されるのはテキストと画像の入力とテキスト出力のみであり、その他の入力タイプは、技術的なインフラ、使いやすさ、安全性が整った段階で、追って公開される予定だ。GPT-4oによる新しい音声モードのアルファ版は、数週間以内にChatGPT Plusでリリースされる予定だという。

だがOpenAIは、進歩はしているものの、GPT-4oには複数のステップを含む複雑なタスクや、文脈やニュアンスの理解など、まだ限界があると述べている。OpenAIは、このモデルをさらに改善するためのフィードバックを求めている。

今回の発表はGPT-4oに焦点を当てた物だったが、次の主要モデルに関する情報が、近日中に発表される予定だと、OpenAIのCTOであるMira Murati氏は述べている。

Sources

- OpenAI: Hello GPT-4o

- Sam Altman: GPT-4o

コメント