Elon Musk氏が設立したAIスタートアップxAIは、AIワークロードに最適化されたサーバーをDell Technologiesから調達する方向で最終調整に入った。Bloombergの報道によると、契約規模は50億ドルを超える見込みとのことだ。xAIは、テネシー州メンフィスに構築中のスーパーコンピューター「Colossus」を強化するため、NVIDIAのGB200半導体を搭載したDell製サーバーを今年中に導入する予定だ。

xAIのスーパーコンピュータ「Colossus」増強

Bloombergによると、DellとxAIの交渉は最終段階にあるものの、契約条件は変更される可能性があるという。xAIは、大規模言語モデル「Grok」シリーズの開発を推進しており、そのための計算基盤として「Colossus」を構築している。

「Colossus」は、2024年9月に稼働を開始し、当初は10万基のNVIDIA製GPUを搭載していた。Dellは、このうち数万基のGPU搭載サーバーを供給している。xAIは、2024年12月の60億ドルの資金調達ラウンド後、「Colossus」のGPU数を20万基に倍増させる計画を発表、長期的には100万基に増強することを目指している。

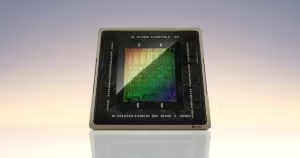

今回、DellがxAIに供給する予定のサーバーは、NVIDIAのGB200設計に基づいている。このシステムは、36基のGB200 Grace Blackwell Superchipを搭載。各Superchipは、1基のGrace CPUと2基のBlackwell B200 GPUで構成されている。

NVIDIAGB200 Grace Blackwell Superchipの性能

GB200 Grace Blackwell SuperchipのCPU「Grace」は、ArmのNeoverse V2コア設計に基づいた72コア、クロック速度3.2GHzのプロセッサだ。一方、Blackwell B200 GPUは、TSMCの4nmプロセスで製造された2080億個のトランジスタを搭載。192GBのHBMを搭載し、AIモデルのデータを格納する。

CPUとGPUは、NVIDIA-C2C技術で接続されており、最大900Gbpsの速度でデータを転送できる。これは、業界標準のPCIe 5の7倍の速度だ。Nvidia-C2Cは、メモリコヒーレンスを提供し、AIクラスタ内のCPUとGPU間のデータコピーの必要性を減らし、処理を高速化するとともに、開発者のハードウェア設定を容易にする。

GB200サーバーは、16のコンピュートトレイに36基のGB200 Grace Blackwell Superchipを格納。各トレイは最大80ペタフロップスの性能を提供し、液冷システムに接続されたコールドプレートによって放熱される。

AIサーバー市場におけるDellの躍進

Bloombergが引用したアナリストの予測によると、DellのAIサーバーの売上高は、2026年1月までの1年間で140億ドルに達し、前年比で40%増加する見込みだ。Dellの株価は、この報道を受けて約4%上昇した。

The Informationによると、xAIはテネシー州メンフィスに加え、第2のデータセンターの建設も検討しているという。同社は、100億ドルの資金調達ラウンドを検討しており、企業価値は750億ドルに達すると評価されている。既存の投資家であるSequoia Capital、Andreessen Horowitz、Valor Equity Partnersなどが出資を検討していると報じられている。

XenoSpectrum’s Take

DellとxAIの大型契約は、AIインフラ市場の急速な拡大を象徴している。NVIDIAの最新GPUを搭載したサーバーの需要は、AIモデルの大規模化に伴い、今後も増加の一途をたどるだろう。Dellは、AIサーバー市場でのリーダーシップを確立しつつあり、今後の成長が期待される。

一方で、xAIの資金調達とデータセンター拡張計画は、同社がOpenAIなどの競合他社に対抗するための積極的な投資を行っていることを示している。AI開発競争が激化する中、計算能力の確保は、企業の競争力を左右する重要な要素となっている。

Sources

コメント