AIアクセラレータ領域において、NVIDIAの支配は圧倒的だ。これに少しでも対抗しようと、先日Intel、Googleらは、CUDAプラットフォームからの脱却を目指したオープンソースのソフトウェア・スイートを開発する団体「Unified Acceleration Foundation (UXL)」を立ち上げたが、ハードウェア面でもNVIDIAの独自技術であるNVLinkに対抗すべく、AIアクセラレータチップ用の新しいインターコネクト規格を開発するために、新しい業界団体「Ultra Accelerator Link(UALink)Promoter Group」を設立した事が明らかとなった。

接続規格を制する

AIデータセンターでは何千、何万と言う莫大な数のGPUが稼働している。そして現在AI企業で取り合いとなっているNVIDIAのAIチップを接続するために用いられているのが、NVIDIAの独自規格であるNVLinkだ。このインターコネクトにより、アクセラレータ間でのデータ転送と通信が高速化され、複雑なタスク(例えば大規模なAIモデルのトレーニング)を効率的に処理できる。

この接続規格は、現代のAIデータセンターシステムの重要な部分であり、接続規格を制する者が、テクノロジー企業が使用するハードウェアを実質的に決定することができる。このような背景から、UALinkグループは、複数の企業がAIハードウェアの進歩に貢献し開発できるオープンスタンダードを確立し、NVIDIAの独自エコシステムに縛られることのないようにしようとしているのだ。このアプローチは、Intelが2019年に作成した、データセンター内のCPUとデバイスやメモリとの間で高速かつ大容量の接続を提供するCompute Express Link(CXL)のような他のオープンスタンダードと似た物と言える。

現在のAIチップ市場のリーダーであるNVIDIAの市場支配力を考えると、同社が新たなUALink Promoter Groupに参加していないのは驚くことではないだろう。ライバルの技術に基づいた仕様をサポートすることに消極的なのは当然と言える。

主要なテクノロジー企業が自社のAIチップ開発に引き続き投資しているため、標準化されたインターコネクト技術の必要性はますます高まっており、特にNVIDIAの影響力に対抗(または少なくともバランスを取る)ための手段としてより重要視されている。

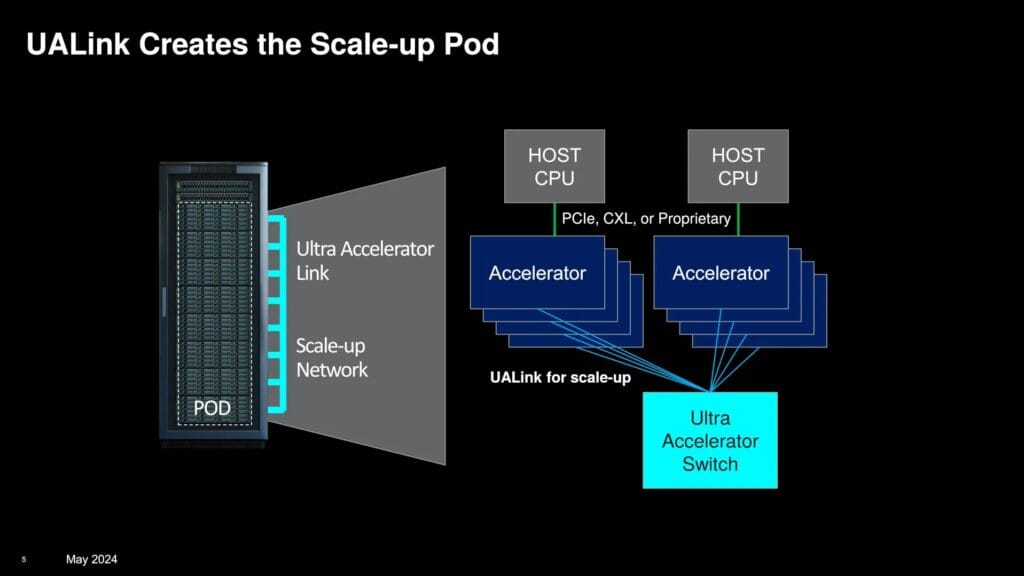

提案されている標準バージョン1であるUALink 1.0は、1つのコンピューティング“ポッド”全体で最大1,024台のAIアクセラレータ(GPUのみ)を接続する。(UALink Promoter Groupによると、UALink 1.0はAMDのInfinity Fabricを含む「オープンスタンダード」に基づいており、AIアクセラレータに接続されたメモリ間の直接的なロードとストアを可能にし、既存のインターコネクト仕様に比べてデータ転送のレイテンシを下げながら、一般的に速度を向上させるという。

AMDのデータセンター・ソリューション担当GMであるForrest Norrod氏は、「業界は、複数の企業がエコシステム全体に価値を付加できるようなオープンな(形式の)、非常に迅速に前進できるスタンダードを必要としている。業界は、どの企業にも邪魔されることなく、イノベーションを急速に進めることができる標準を必要としています」と、述べている。

このグループは、2024年後半にUALink仕様の継続的な開発を管理するためのUALinkコンソーシアムを設立する予定だ。UALink 1.0は、コンソーシアムに参加する企業に対して同時期に提供され、より広帯域幅の更新されたUALink 1.1は2024年第4四半期に登場する予定である。

最初のUALink製品は、今後2年以内に利用可能になると、Norrod氏は述べているが、AIデータセンターマーケットが成長する中で、NVIDIAが独自の技術をさらに拡大するのに十分なリードタイムを提供する可能性もありそうだ。

Sources

コメント