AppleはAI分野での同社の取り組みをほとんど明らかにしていない。Siriがあまりに使えないからAI研究ではOpenAI、MicrosoftやGoogleと比較して遅れをとっているように見えるが、どうやら同社の取り組みは想像以上に進んでいるようだ。今回明らかになった同社の2つの論文からそれぞれを探ってみよう。

オンデバイスでのAI処理の実現が容易に

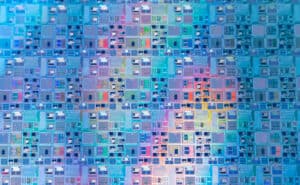

Appleは、iPhoneやその他のApple製デバイスが、スピードやパフォーマンスを損なうことなく、パワフルなAIモデルをデバイス上で実行できるようにする、画期的な技術に取り組んでいる。その秘密は、アプリや写真を保存しているのと同じメモリであるフラッシュメモリを使用して、自然言語を理解・生成できる大規模言語モデル(LLM)を実行することにある。

LLMは、人間と会話し、有用な情報やサービスを提供することができる、AppleのSiriのようなAIチャットボットやアシスタントのバックボーンである。しかし、LLMはメモリを大量に消費し、適切に機能するためにはギガバイト単位のRAMを必要とする。このため、RAM容量が限られているiPhoneなどのモバイル・デバイスにとっては課題となる。

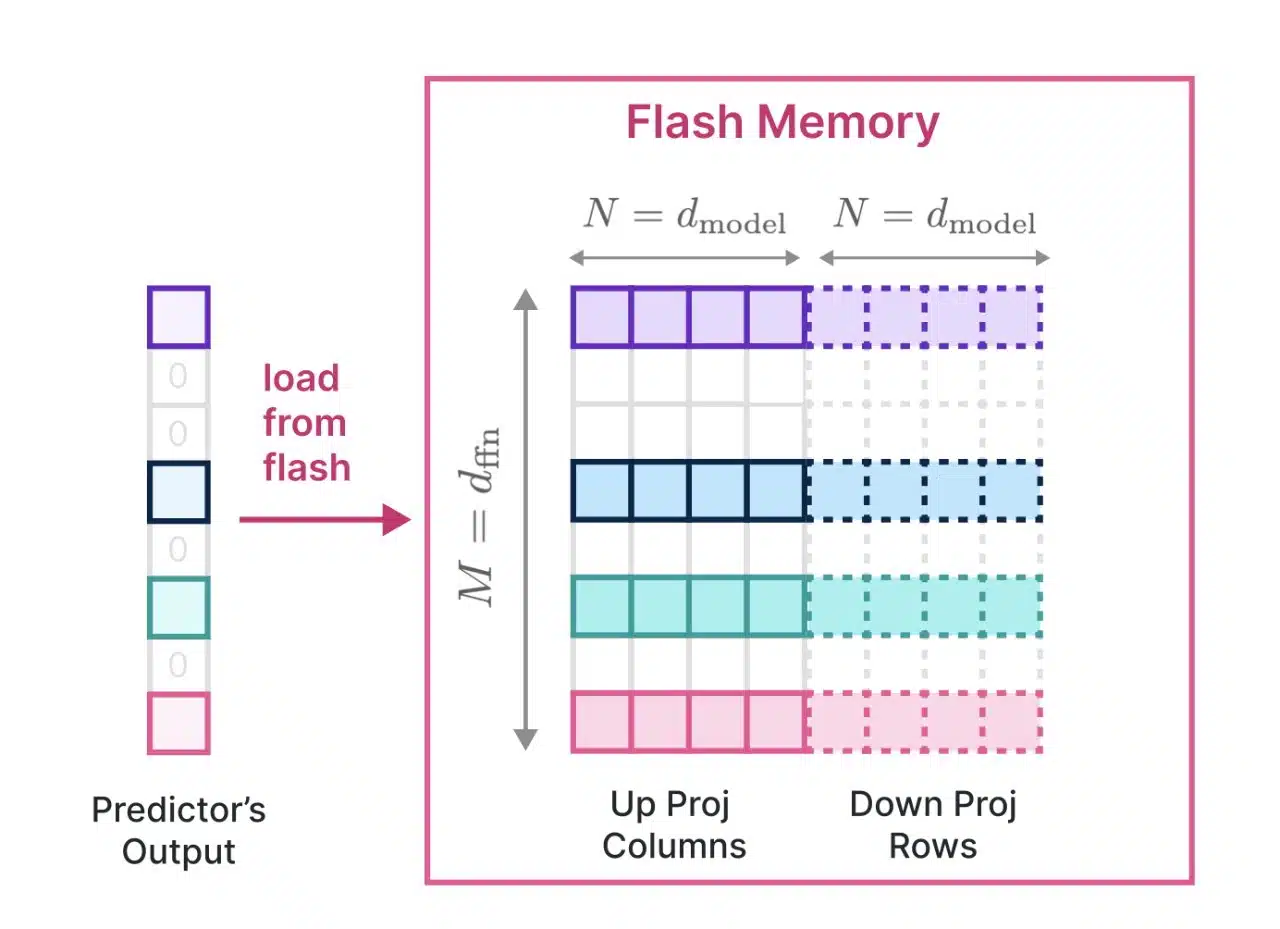

この課題を克服するため、Appleの研究者たちはLLMのデータの保存とアクセスに、RAMよりも豊富で安価なフラッシュメモリを活用する新しい技術を考案した。「LLM in a flash: Efficient Large Language Model Inference with Limited Memory」と題された新しい研究論文の中で、研究チームはこれを可能にする2つの重要な技術革新について述べている。

1つ目はウィンドウ処理である。このリサイクル技術により、フラッシュ・メモリとRAMの間で転送する必要のあるデータ量が削減される。LLMは毎回新しいデータをロードする代わりに、すでに処理されたデータの一部を再利用することで、時間とエネルギーを節約する。

そして、フラッシュ・メモリからのデータ検索速度を向上させる読み出し技術である「Row-Column Bundling」が登場する。LLMは一度に1ワードを読み出すのではなく、より大きなデータの塊を同時に読み出すことで、効率とスループットを向上させる。研究者らは、この技術により、利用可能なRAMサイズの2倍までのLLMを実行でき、CPUでは4~5倍、GPUでは20~25倍のスピードアップが可能だと主張している。また、この技術は「リソースが限られた環境で高度なLLMを展開するために特に重要であり、それによってその適用性とアクセシビリティが拡大する」とも述べている。

このブレークスルーは、Appleとそのユーザーにとって大きな意味を持つ。将来のiPhoneでは、クラウドサーバーに依存したりプライバシーを侵害したりすることなく、より高度で洗練されたAIモデルをデバイス上で実行できるようになるかもしれない。これにより、リアルタイムの言語翻訳、より優れた音声認識、よりスマートな応答など、Siriの機能が強化される可能性がある。また、写真撮影や拡張現実(AR)、その他の領域でも、AIを活用した新たな機能が実現する可能性がある。

HUGS

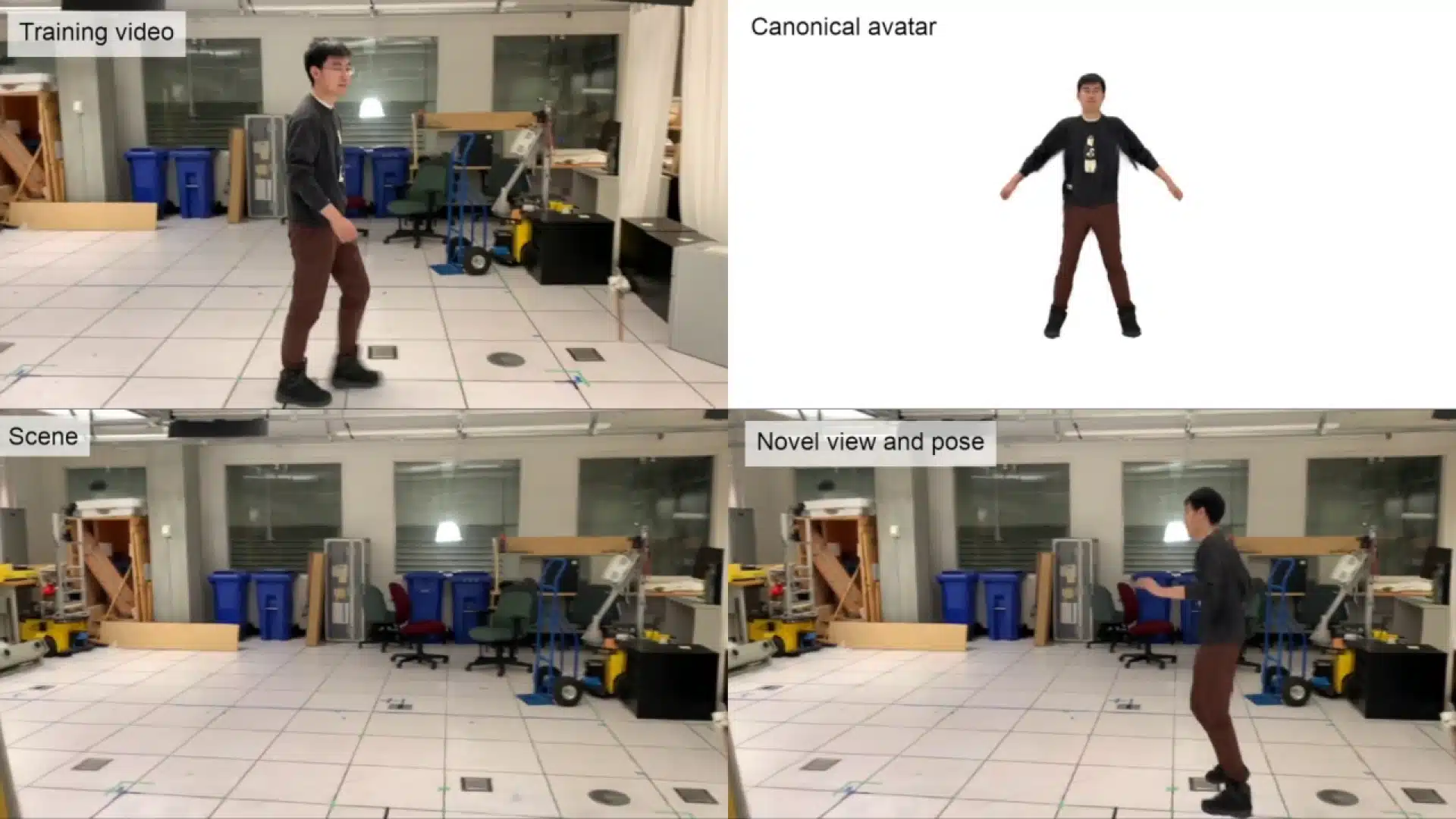

別の研究論文では、Appleの研究者たちが、短い単眼動画からアニメーション化された3Dアバターを生成するHUGS(Human Gaussian Splats)と呼ばれる新しい手法を提案している。研究論文の筆頭著者であるMuhammed Kocabas氏によると、HUGSは、わずか50~100フレームの単眼動画から、静的なシーンと完全にアニメーション可能な人間のアバターを切り離すことを自動的に学習できる。

この技術は、人間と背景シーンの両方を表現するために3Dガウス散布を使用し、人間モデルを初期化するためにSMPLと呼ばれる統計的体型モデルを使用する。しかし、HUGSはガウシアンを逸脱させ、衣服や髪のようなディテールをキャプチャする。

新しいニューラル変形モジュールは、線形ブレンドスキニングを用いてガウシアンをリアルにアニメーションさせ、アバターの姿勢を変えながらアーチファクトを回避します。HUGSは人間の斬新なポーズ合成と、人間とシーンの両方の斬新なビュー合成を可能にする。

これまでのアバター生成手法と比較して、HUGSはトレーニングおよびレンダリングにおいて最大100倍高速であり、3D再構築の品質において最先端の技術を凌駕している。研究者らは、一般的なゲーム用GPUでわずか30分の最適化を行っただけで、フォトリアリスティックな結果が得られることを実証している。

Appleの生成AIロードマップ

この画期的な技術により、バーチャル試着、テレプレゼンス、合成メディアの新たな可能性が開ける。また、iPhoneのカメラを使って斬新な3Dシーンを作成することも可能になるだろう。HUGSのスピードと効率は、Appleの研究者にとって実に素晴らしい成果である。

Bloombergによると、Appleはすでにその生成AI研究をSiriに統合することに取り組んでいるという。同社は2023年2月にAIサミットを開催し、大規模な言語モデル研究について従業員に説明した。Appleは、AIと深く統合され、複雑なクエリやタスクを処理できる、よりスマートなバージョンのSiriを目指している。Appleはまた、Siriがメッセージアプリとやりとりする方法を更新し、ユーザーが複雑な質問に答えたり、文章をより効果的に自動補完したりできるようにすることも計画している。それ以外にも、Appleは可能な限り多くのアプリにAIを追加すると噂されている。

Appleはまた、「Ajax」と呼ばれる独自の生成AIモデルを開発しており、世界で最も先進的なAIモデルであるOpenAIのGPT-3やGPT-4に匹敵するように設計されている。Ajaxは2,000億個のパラメータで動作し、言語理解と生成における複雑さと能力の高さを示している。社内では「Apple GPT」として知られるAjaxは、Apple全体の機械学習開発を統一することを目指しており、AIをAppleのエコシステムに深く統合する広範な戦略を示唆している。

The InformationとアナリストのJeff Pu氏によると、AppleはiOS 18が登場する2024年後半頃に、iPhoneとiPadでいくつかの生成AI機能を利用できるようになるという。これはAppleとそのユーザーにとってゲームチェンジャーとなる可能性があり、デバイスとの新たなレベルのインタラクティビティとエンゲージメントを提供する。

論文

コメント