米AI企業Cerebrasは、北米と欧州に6つの新AIデータセンターを設立すると発表した。CS-3ウェハースケールエンジンを搭載したこれらの施設は、AI推論処理能力を20倍に拡大し、1秒あたり4000万Llama 70Bトークンを処理可能になる。同社はこの拡張により「世界最大の高速AI推論クラウド」の提供を目指している。

新データセンターの展開計画

Cerebrasが展開するデータセンターの場所と稼働予定時期は以下の通りだ:

- サンタクララ(カリフォルニア州):既に稼働中

- ストックトン(カリフォルニア州):既に稼働中

- ダラス(テキサス州):既に稼働中

- ミネアポリス(ミネソタ州):2025年第2四半期

- オクラホマシティ(オクラホマ州):2025年第3四半期

- モントリオール(カナダ):2025年第3四半期

- 米国中西部/東部:2025年第4四半期

- 欧州(フランス):2025年第4四半期

オクラホマシティとモントリオールの施設はCerebrasが完全所有する一方、他の施設は戦略的パートナーであるG42と共同で運営される。全体の処理能力の85%が米国に配置されることで、米国のAIインフラとリーダーシップの強化に貢献するとしている。

米国最大となるミネアポリス施設は512台のCS-3 AIアクセラレータを備え、FP16計算で64エクサFLOPSの処理能力を提供する予定だ。オクラホマシティ施設は2025年6月に稼働予定で、300以上のCS-3システムを収容する。Scale Datacenterとのパートナーシップで運営され、竜巻や地震から保護する設計、3重冗長電源ステーションを備えている。

Cerebrasの技術的優位性とNVIDIAへの挑戦

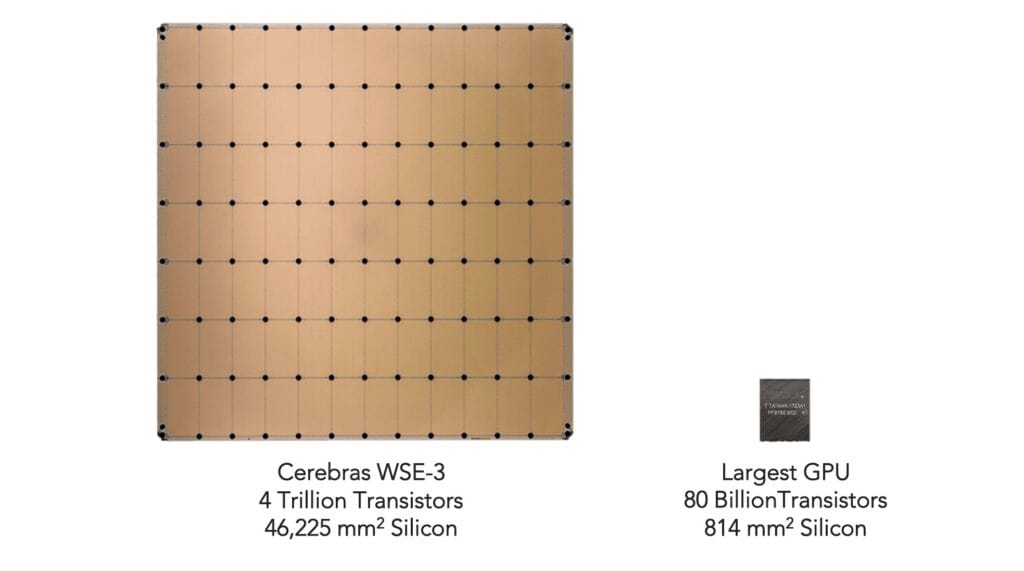

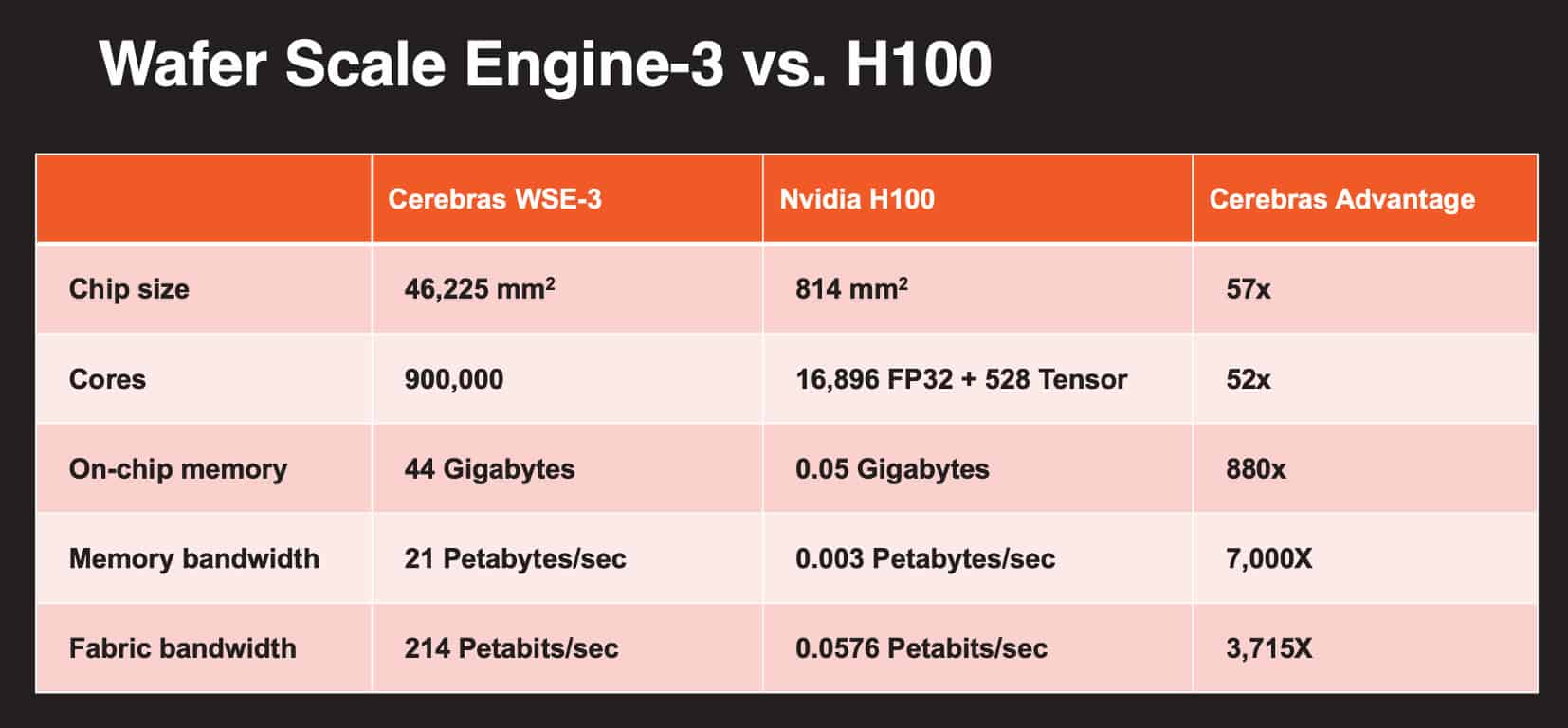

Cerebrasの強みは、ディナープレートサイズ(46,225 mm²)のシリコンウェハー全体を1つのプロセッサとして使用する独自のアーキテクチャにある。各CS-3プロセッサには4兆のトランジスタ、90万コア、44GBのSRAMが搭載されている。

このシステムは高度にスパースなFP16パフォーマンスで125ペタFLOPSを生成する能力があり、NVIDIAのH100/H200の2ペタFLOPS、最新のBlackwell GPUの5ペタFLOPSと比較しても大幅に高性能だ。

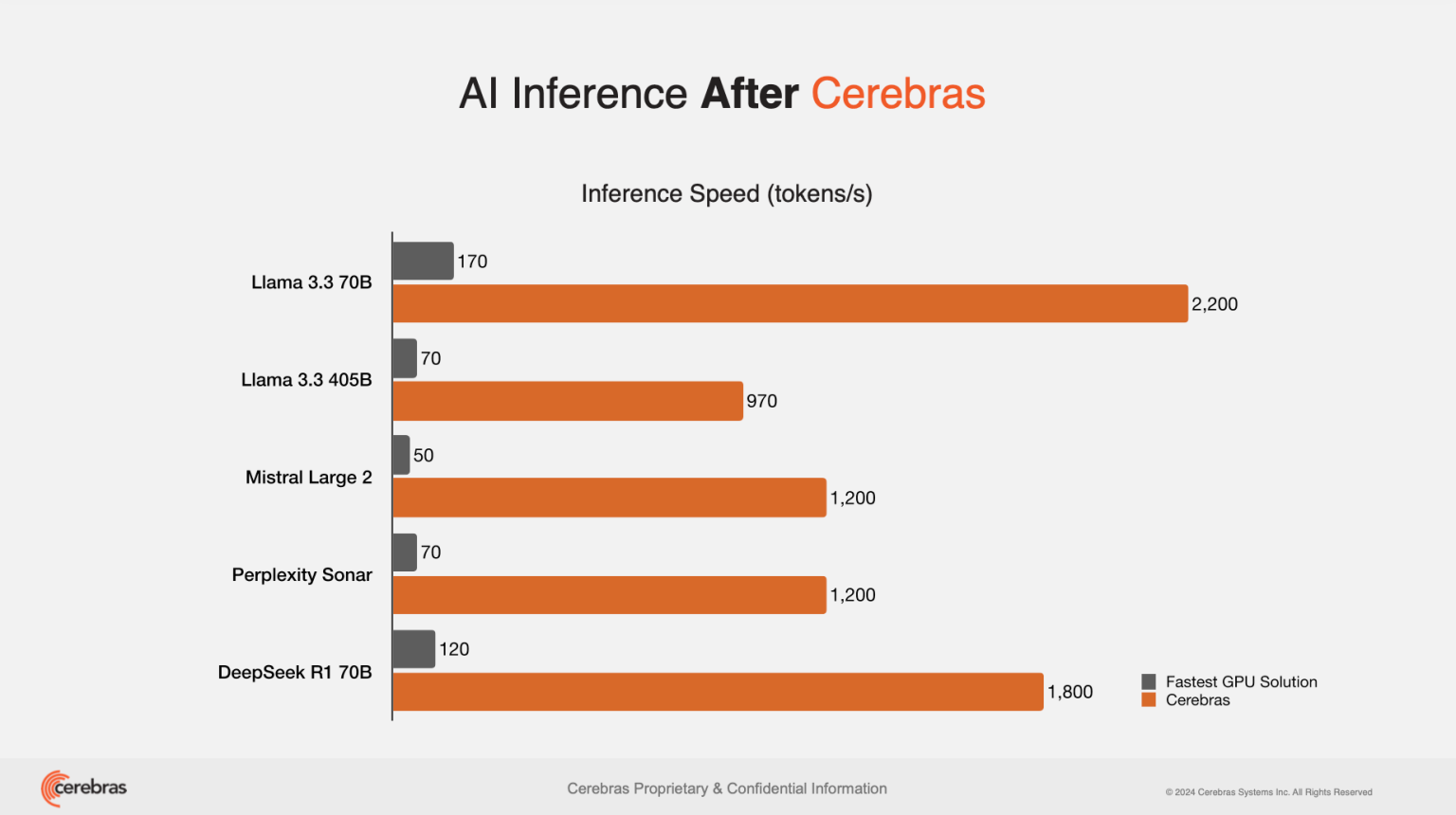

Cerebrasは当初モデルトレーニングに特化していたが、現在は推論サービスにも注力している。同社はLlama 3.3 70Bを1秒あたり2,200トークンで処理できると主張している。これはGPUベースのソリューションより10〜70倍高速とされる。

この高性能は、LLM推論のメモリ帯域幅依存性を活かしている。CS-3は21ペタバイト/秒のメモリ帯域幅を提供し、H100の3.35テラバイト/秒を大きく上回る。さらに「投機的デコーディング」技術により、トークン処理量を最大6倍向上させている。

戦略的パートナーシップと主要顧客

Cerebrasは2024年8月に高速推論サービスを発表して以来、主要なAI企業から強い需要を受けている。現在の顧客には以下が含まれる:

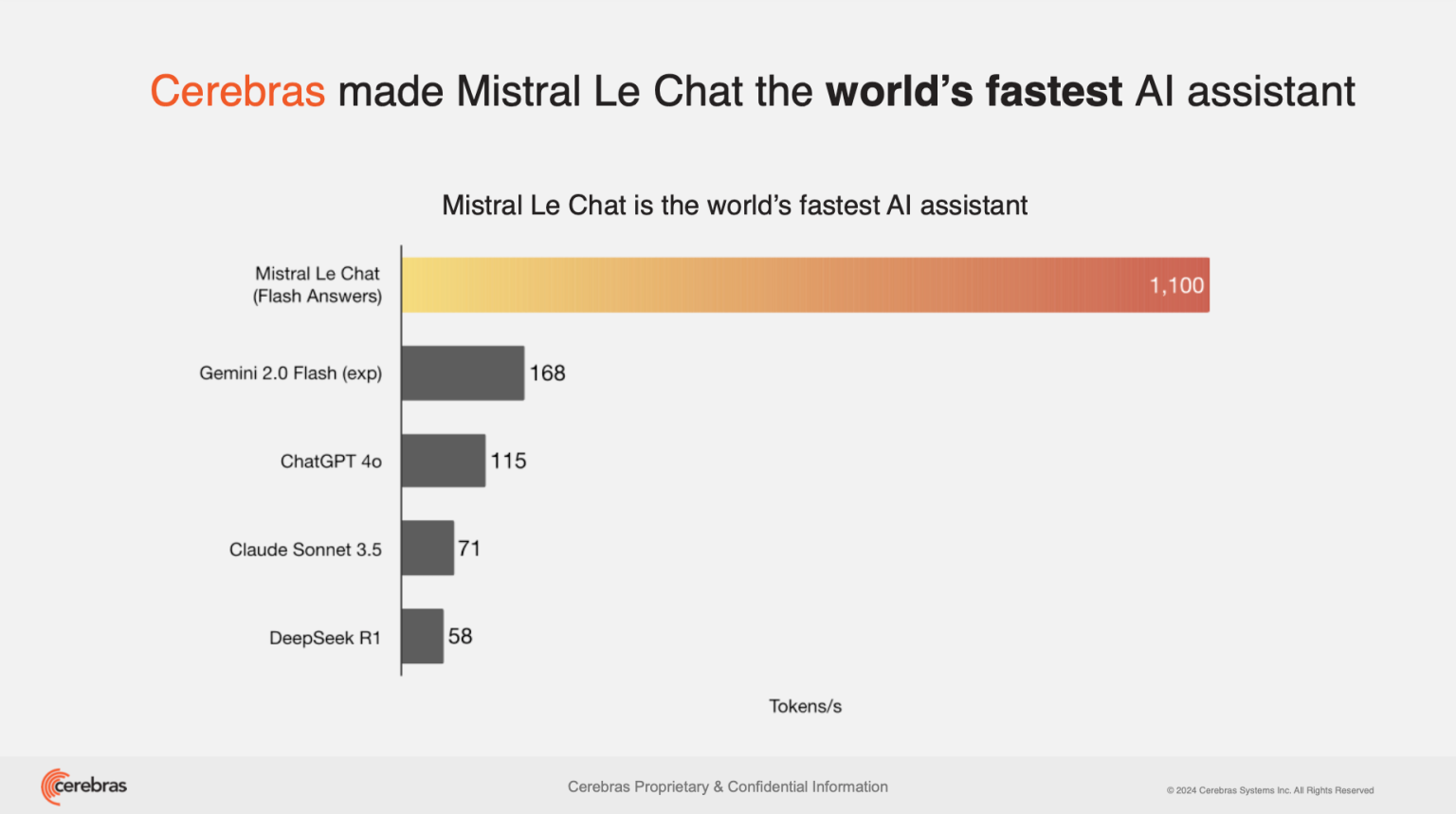

- Mistral AI:フランスの主要AIスタートアップで、AIアシスタント「Le Chat」に採用

- Perplexity:AI検索エンジンで、瞬時の検索結果提供に利用

- HuggingFace:「AIのGitHub」として知られるモデルリポジトリ

- AlphaSense:市場インテリジェンスプラットフォーム、フォーチュン100社の約85%にサービス提供

特筆すべきはHugging Faceとの新パートナーシップだ。この提携により、500万人以上の開発者がワンクリックでCerebrasの高速推論サービスにアクセス可能になる。開発者はHugging Faceのプラットフォームで推論プロバイダーとして「Cerebras」を選択するだけでよい。

AlphaSenseとの提携も重要な顧客獲得事例である。同社は「世界のトップ3クローズドソースAIモデルベンダー」からCerebrasのオープンモデルに切り替えるという。これにより、処理時間が5秒以上から「瞬時」に短縮されたとされる。

AI業界への影響と意義

Cerebrasの大規模な推論インフラ拡大は、NVIDIAが支配するAIハードウェア市場に変化をもたらす可能性がある。特にDeepSeek R1やOpenAI o3などの「推論モデル」処理に優位性を持つ。これらのモデルは「思考の連鎖」技術を使用するため従来は数分の処理時間を要したが、Cerebrasのシステムでは数秒で実行可能だという。

同社の価値提案は速度とコストの組み合わせにある。Meta社のLlama 3.3 70BはOpenAIのGPT-4と同等の知能テストスコアを達成しながら、運用コストは大幅に低い(GPT-4の約4.40ドルに対し、約0.60ドル)とされる。

Cerebrasは高速推論に特化することで、特定の価値の高いセグメントでリーダーシップを確立する戦略を採っている。特に注力する分野は、リアルタイムの音声・ビデオ処理、推論モデル、コーディングアプリケーションの3つだ。

CerebrasのCOOであるDhiraj Mallick氏は「Cerebrasは比類のないパフォーマンス、スケール、効率性で米国のAIリーダーシップの未来を加速している。これらの新しいグローバルデータセンターは、次世代のAIイノベーションのバックボーンとなる」と述べている。

Source